❌ Daten in Excel schützen ❌ Datenschutz in Excel neu gedacht – ohne unsichere Passwortlösungen ❗

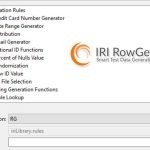

Datenschutz in Excel neu gedacht: Verlassen Sie sich nicht länger auf Tabellen-Passwörter, die längst kein verlässlicher Schutz mehr sind. Wenn es um sensible Daten geht, braucht es mehr als reine Zugriffsbeschränkungen. Mit IRI CellShield heben Sie den Datenschutz in Microsoft Weiterlesen